Cluster de Computadores

A infraestrutura para computação de alto desempenho do LIMC (Laboratório Integrado de Modelagem Computacional) é composta por um cluster de computadores, no-breaks de grande autonomia e aparelhos de ar-condicionado de grande porte, todos adquiridos com recursos MCT/FINEP/CT-INFRA PROINFRA 01/2007 e MCT/FINEP/CT-INFRA 01/2008.

Tratam-se de equipamentos multiusuário, atendendo a discentes de graduação (Graduações em Engenharia Computacional, Ciência da Computação, Sistemas de Informação, Engenharia Elétrica), mestrado e doutorado de distintos cursos (Pós-Graduações em Modelagem Computacional e Ciência da Computação), bem como professores de diversos departamentos da UFJF (Ciência da Computação-DCC, Mecânica Aplicada e Computacional-MAC, Matemática-MAT, Estatística-EST, Engenharia de Produção e Mecânica-EPD) e de outras instituições (Universidade Federal de São João Del-Rey-UFSJ, Universidade Federal de Ouro Preto-UFOP, CEFET-MG Leopoldina, IFET Sudeste Cataguases). Trata-se, portanto, de um equipamento de grande relevância não só para a UFJF, como também para outras instituições públicas de ensino e pesquisa da região.

O equipamento atende, a cada semestre letivo, cerca de 30 docentes; 80 alunos de graduação em três disciplinas distintas; 31 alunos de Mestrado e 49 de Doutorado. Em média, o equipamento executa a mais de 800 tarefas computacionais por dia.

O cluster é composto por um total de 54 nós. Destes, um nó é denominado front-end, disponibilizando, dentre outras funções, espaço de armazenamento. Os demais 53 nós são denominados escravos, tendo o papel principal de realizar processamento. Os nós possuem CPUs com quantidade de núcleos distintas (variando de 8 a 64). Alguns destes nós de processamento possuem GPUs (placas aceleradoras), utilizadas em pesquisas em que um grande volume de dados precisa ser processado.

Este equipamento está registrado na Plataforma Nacional de Infraestrutura de Pesquisa (PNIPE) do MCTI:

Comitê Gestor

- Prof. Marcelo Lobosco (DCC/UFJF) – Coordenador do LIMC

- Prof. Bernardo M. Rocha (DCC/UFJF) – Coordenador do PPG em Modelagem Computacional

- Reginaldo Santana (Faculdade de Engenharia/UFJF) – Técnico

Comitê de Usuários

- Prof. Rodrigo Weber dos Santos (DCC/UFJF)

- Prof. Leonardo Goliatt (MAC/UFJF)

- Prof. Flávia de Souza Bastos (MAC/UFJF)

- Prof. Rafael Sachetto Oliveira (DCOMP/UFJS)

Agenda de Utilização

Criação de Conta e Agenda de Uso do Cluster

Não é necessário agendar um dia ou horário para o uso do cluster, pois é empregado um sistema automatizado para a execução das tarefas computacionais. Contudo, faz-se necessária a abertura de uma conta para o usuário. Para tal, o coordenador do projeto deve procurar a coordenação do PPG (email), apresentando um breve projeto onde conste título, um breve resumo, uma justificativa para o uso do cluster, nome do(s) aluno(s) que irão acessar o cluster e período em que os mesmos cursaram as disciplinas Programação Paralela (DCC125) ou Computação em Ambientes Distribuídos (219004) oferecidas pelo Departamento de Ciência da Computação e pelo Programa de Pós-Graduação em Modelagem Computacional, respectivamente.

O sistema OGE (Oracle Grid Engine) é utilizado para o agendamento das tarefas. O sistema aceita, escalona, despacha e gerencia automaticamente a execução de tarefas, permitindo que os usuários interessados em usar o cluster especifiquem as características de hardware necessárias para a execução de suas tarefas, com o sistema OGE casando-as com a disponibilidade das máquinas. O sistema colocará o pedido do usuário em uma fila de execução, atendendo aos pedidos de modo a maximizar o uso dos recursos computacionais. Deste modo, o cluster está disponível para aceitar tarefas 24 horas por dia, 7 dias por semana. As tarefas serão executadas quando os recursos solicitados estiverem disponíveis e pedidos anteriores para uso dos mesmos recursos tiverem finalizado. Os recursos solicitados são alocados de modo exclusivo aos usuários sem tempo pré-determinado para que finalizem a sua execução.

É possivel, em caráter de excepcional (deadlines para defesa ou entrega de artigos), agendar via OGE recursos para execução urgente. Entre em contato com a coordenação para saber como proceder.

Manuais de Utilização

Histórico de Uso

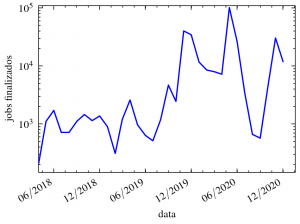

A figura abaixo ilustra o histórico de jobs finalizados no cluster desde o mês de Abril de 2018.

Projetos em andamento

Otimizaçao multi-objetivo de componentes de uma turbina eólica

- Membros: Afonso Celso de Castro Lemonge (MAC/UFJF), Patricia Habib Hallak (MAC/UFJF), Lucas de Landa Couto (PIBIC/CNPq/UFJF), Josué Yosshikazu de Oliveira Saito (VIC/UFJF), Eric Vargas Loureiro (Doutando/PPGMC), Rodrigo Perobeli Silva Costa (Mestrando/PPGMC)

- Palavras-chave: Turbinas eólicas; Pás de turbinas eólicas; Otimização estrutural e aerodinâmica; Otimização multi-objetivo.

- Resumo: A energia eólica é sabidamente um tipo de energia limpa e renovável onde não ocorre a emissão de poluentes e que, devidamente explorada, não gera qualquer tipo de impacto ambiental. Diferentemente de restrições da energia originada por fontes hídricas, ela pode ser obtida em locais diversificados desde que planejada de forma adequada e geralmente obtida por uma ou um conjunto de torres eólicas. Um conjunto de torres eólicas compõe uma usina de geração de energia eólica também conhecida como “fazenda de torres eólicas”. Em cada torre o vento movimenta hélices que estão ligadas a um gerador de eletricidade resultando na fonte de energia desejada. O projeto das pás ou hélices de turbinas eólicas não é uma tarefa trivial com características multidisciplinares como os aspectos aerodinâmicos, estruturais, ciência dos materiais, projetos otimizados, etc. Por exemplo, projetos otimizados têm como objetivo principal a minimização da massa ou peso da hélice. As formulações considerando um único objetivo são as mais usuais e, evidentemente, com a consideração de um conjunto de restrições que devem ser rigorosamente satisfeitas. Nos últimos anos uma série de métodos foram propostos para otimização multidisciplinar das hélices das turbinas eólica. Neste projeto são estudados os problemas de otimização estrutural e aerodinâmica com múltiplos objetivos da hélice de uma turbina eólica baseada em um dos modelos do Laboratório de Energias Renováveis do Departamento de Energia dos Estados Unidos (https://www.nrel.gov/), mundialmente conhecido como NREL 5MW. O principal objetivo é desenvolver uma metodologia para o projeto estrutural otimizado da hélice de uma turbina eólica baseado no modelo NREL 5MW considerando conjuntamente vários objetivos conflitantes nas formulações. Os algoritmos evolucionários são usados como otimizadores e a análise estrutural e aerodinâmica é feita via modelagem em elementos finitos dos materiais compósitos que constituem a pá da turbina.

Development of a hybrid computational intelligent models for global solar radiation prediction

- Coordenador: Leonardo Goliatt da Fonseca

- Membros: Leonardo Goliatt da Fonseca, Zaher Mundher Yaseen (Asia University), Camila Martins Saporetti (UEMG), Lucas Pereira Verneck (PGMC/UFJF), Samuel Alves Basilio (PGMC/UFJF)

- Palavras Chave: Global solar radiation, hybrid computational intelligent, energy harvesting, parametric analysis

- Resumo: Providing an accurate and reliable solar radiation prediction is highly significant for optimal design and management of thermal and solar photovoltaic systems. It is massively essential for producing renewable and clean energy production. In the current project, an exploration of newly developed computation intelligent models based on the hybridization of evolutionary algorithms with machine learning models for building robust predictive models for daily scale solar radiation. The proposed hybrid models are examined at four meteorological stations) located in Africa and the Middle West. The prediction matrix is constructed using several related climate parameters. The computational framework aims at consistently enhanced prediction accuracy against the existing methods proposed in the literature. The resulting method has the potential to be used as a surrogate tool for solar radiation prediction on the stations. The findings of this study contribute to a growing body of literature towards advancing the study of machine learning methods for predicting renewable energy production.

Estimation of natural streams longitudinal dispersion coefficient using hybrid evolutionary machine learning model

- Coordenador: Leonardo Goliatt da Fonseca

- Membros: Leonardo Goliatt da Fonseca, Zaher Mundher Yaseen (Asia University)

- Palavras Chave: longitudinal dispersion coefficient; automated machine learning, natural streams

- Resumo: Among several essential indicators for river engineering sustainability, the longitudinal dispersion coefficient (Kx) is the main parameter that defines the transport of pollutants in natural streams. Accurate estimation of Kx has always been a challenging mission for hydrologists owing to the high stochasticity and non-linearity of this hydraulic-environmental parameter. This project aims at developing hybrid machine learning (ML) models assisted by evolutionary input selection algorithms to estimate Kx in natural streams. The estimation model is developed based on geometric and hydraulic river system parameters. The evolutionary feature selection (FS) approach is integrated with the proposed estimation model to configure the influential parameters toward the Kx. The proposed hybrid evolutionary models arise as robust and reliable alternative computer aid technology for predicting the longitudinal dispersion coefficient in natural streams.

Hybrid machine learning models for estimating total organic carbon from mineral constituents in core samples of shale gas fields

- Coordenador: Leonardo Goliatt da Fonseca

- Membros: Leonardo Goliatt da Fonseca, Camila Martins Saporetti (UEMG), Rodrigo Oliveira Silva (BIC/UFJF), Egberto Pereira (UERJ), Leonardo Costa Oliveira (Petrobras)

- Palavras Chave: Machine Learning, Evolutionary Optimization, Total Organic Carbon, Geology

- Resumo: The analysis of total organic carbon (TOC) contents is an important activity in exploring potentially hydrocarbon-generating intervals. Petroleum source rocks have, by definition, high TOC values due to the accumulation of organic matter in anoxic and low-energy deposition environments over geological time. Such petroleum generation is called conventional because it results from the increasing temperature and pressure conditions during continuous sedimentary burial. On the other hand, unconventional generation refers to reserves formed due to another heat source, for example, associated with intrusive igneous emplacement. In the last decade, there has been a growing economic interest in exploring unconventional hydrocarbon reserves because of the abundance of its occurrences. However, finding ways to assess the total organic carbon (TOC) content at lower cost and time-consuming laboratory experiments is becoming more fundamental due to the importance of TOC in the analysis of the composition of these resources. This project aims at developing data-driven models to predict TOC using a hybrid approach integrating machine learning models and evolutionary algorithms, The predictions can be used to further the exploratory geological analysis, especially those related to prospects of unconventional oil-gas resources.

Quantificação de Incertezas e Análise de Sensibilidade em modelos da eletrofisiologia cardíaca

- Coordenador: Prof. Rodrigo Weber dos Santos (DCC / UFJF)

- Membros: Yan Werneck (IC / UFJF)

- Palavras-chave: quantificação de incerteza, eletrofisiologia cardíaca, emuladores, computação de alto desempenho

- Resumo: Este projeto vista comparar diferentes técnicas para emulação de modelos matemáticos da eletrofisiologia cardíaca que descrevem a geração de potencial de ação. Em particular serão estudados emuladores baseados na expansão em Caos Polinomial e em processos Gaussianos para a realização de análises de sensibilidade e propagação de incerteza nos modelos e suas quantidades de interesse.

Quantificação de Incertezas e Análise de Sensibilidade em modelos da mecânica cardíaca

- Coordenador: Prof. Bernardo Martins Rocha (DCC / UFJF)

- Membros: Joventino de Oliveira Campos (CEFET-MG Campus Leopoldina), Berilo de Oliveira Santos (IC / UFJF)

- Palavras-chave: quantificação de incerteza, biomecânica cardíaca, emuladores, computação de alto desempenho

- Resumo: O objetivo deste projeto é analisar modelos matemáticos da biomecânica cardíaca utilizando técnicas de quantificação de incerteza e análise de sensibilidade baseadas na expansão em Caos Polinomial. Em particular serão avaliados influências de parâmetros constitutivos, parâmetros que controlam a orientação das fibras no tecido cardíaco (microestrutura do tecido) e também parâmetros geométricos que descrevem e caracterizam a forma do ventrículo esquerdo humano.

Paralelização de métodos estocásticos para quantificação de incertezas em modelos de terapia por hipertermia

- Coordenador: Prof. Ruy Freitas Reis (DCC / UFJF)

- Membros: Gustavo Resende Fatigate (Mestrado PPGMC); Antônio Marchese Bravo Esteves (VIC/UFJF)

- Palavras Chave: Hipertermia; Biotransferência de Calor; Quantificação de Incertezas; Computação de Alto Desempenho; Modelagem Matemática

- Resumo: Segundo a Organização Mundial de Saúde (OMS) em conjunto com a Organização Pan-Americana da Saúde (OPAS) o câncer é a segunda principal causa de morte no mundo e foi responsável por 9,6 milhões de mortes em 2018. A nível global, uma em cada seis mortes está relacionada à doença. Existem mais de 100 tipos de câncer, sendo os mais comuns os de pulmão, mama, colorretal, próstata, câncer de pele não-melanoma e estômago. Uma alternativa aos tratamentos convencionais que tem sido desenvolvida é realizada por meio de hipertermia onde o calor é empregado para superaquecer o tecido até uma determinada temperatura que leva à necrose das células, evitando a necessidade de um processo cirúrgico. Assim, esta pesquisa almeja utilizar métodos estocásticos para analisar e quantificar as incertezas relacionadas aos parâmetros de modelos matemáticos que descrevem um tratamento baseado em hipertermia.

Análise estocástica de modelos matemáticos do sistema imune em ambiente paralelo

- Coordenador: Prof. Ruy Freitas Reis (DCC / UFJF)

- Membros: Gustavo Morais Rodrigues Costa (BIC/UFJF)

- Palavras Chave: Imunologia Computacional; Quantificação de Incertezas; Computação de Alto Desempenho; Modelagem Matemática

- Resumo: De acordo com a Organização Pan-Americana da Saúde (OPAS), as doenças infecciosas possuem grande influência na saúde pública na região das Américas e em todo o mundo. A Organização Mundial da Saúde (OMS) indicou que doenças como dengue, febre amarela, Doença de Chagas, malária, e outras doenças causadas por micro-organismos conhecidos como patógenos representam mais de 17% das doenças infecciosas no mundo, causando mais de 700 mil mortes por ano. A maioria das infecções que afetam os seres humanos é causada por micro-organismos conhecidos como patógenos. Um dos sinais conhecidos de uma resposta inflamatória do sistema imune a uma infecção é a edematização do local infeccionado. Modelos matemáticos capazes de equacionar a dinâmica da patofisiologia da formação de edemas é algo novo e com muitas perguntas em aberto. Além disso, possuem diversas aplicações na biologia computacional e biomecânica.

Modelagem Matemática da Resposta Imunológica no Sistema Nervoso Central

- Coordenadora: Prof. Bárbara de Melo Quintela (DCC / UFJF)

- Membros: Matheus Avila Moreira de Paula (VIC/UFJF); Joao Stephan Silva Mauricio (GET/Engcomp)

- Palavras-chave: Modelagem Matemática, Equações diferenciais, Imunologia Computacional

- Resumo: O encéfalo possui características peculiares que distinguem a sua resposta inflamatória de outros órgãos tornando-o menos suscetível à inflamação. No entanto, essa proteção não impede que processos inflamatórios ocorram. Os macrófagos residentes no SNC são chamados de “microglia” e há indícios de que a microglia além de realizar fagocitose (função principal dos macrófagos) atue também como célula apresentadora de antígenos, ativando a resposta específica dos linfócitos T. A resposta inflamatória causada pela ativação da microglia e linfócitos gera danos que estão associados a doenças degenerativas como Esclerose Múltipla (EM), doença de Alzheimer e Parkinson. Propõe-se com o presente projeto, a adaptação de modelos matemáticos de equações diferenciais parciais e ordinárias para representar, respectivamente, a ação da resposta imunológica com ativação da microglia no sistema nervoso central e ativação das células T e posterior produção de anticorpos nos linfonodos periféricos. O modelo será calibrado utilizando dados obtidos na literatura utilizando método de evolução diferencial e espera-se melhorar a compreensão dos processos envolvidos em doenças degenerativas.

Efeitos da fibrose heterogênea e difusa causada pela isquemia do tecido cardíaco: um estudo computacional

- Coordenador: Prof. Rafael Sachetto Oliveira (UFSJ)

- Resumo: Os processos biofísicos envolvidos nos fenômenos de propagação elétrica no coração, contração celular, e controle do metabolismo energético são extremamente complexos e de natureza altamente não linear. Modelos computacionais se tornaram ferramentas importantes para o estudo e a compreensão de fenômenos com esse nível de complexidade, por permitirem que informações coletadas a partir de experimentos em diferentes escalas físicas sejam combinadas para se obter um entendimento melhor da funcionalidade do sistema como um todo. Como já era de se esperar, a alta complexidade dos processos biofísicos se traduz em complexos modelos matemáticos e computacionais. Os modelos cardíacos modernos são descritos por sistemas nãolineares de equações diferenciais parciais com milhões de variáveis e centenas de parâmetros. O modelo bidomínio é considerado uma das mais completas descrições da atividade elétrica do tecido cardíaco. Utilizando hipóteses apropriadas as equações do bidomínio podem ser reduzidas para um modelo mais simples, denominado monodomínio, o qual é menos intensivo computacionalmente. Infelizmente, as simulações em larga escala, tais como as resultantes da discretização de um coração inteiro, permanecem como um desafio computacional. Apesar das dificuldades e da complexidade associadas à implementação e uso desses modelos, os benefícios e aplicações justificam seu uso. Os modelos computacionais têm sido utilizados durante testes de novos fármacos, desenvolvimento de novos dispositivos médicos e novas técnicas de diagnóstico não-invasivo para diversas doenças cardíacas. O proponente deste projeto, juntamente com seus colaboradores vem realizando estudos computacionais para compreender com mais detalhes os efeitos da fibrose heterogênea e difusa causada pela isquemia do tecido cardíaco.

Algoritmos paralelos e adaptativos no tempo e no espaço para modelagem do coração

- Coordenador: Prof. Rafael Sachetto de Oliveira (UFSJ)

- Resumo: Os processos biofísicos envolvidos nos fenômenos de propagação elétrica no coração, contração celular, e controle do metabolismo energético são extremamente complexos e de natureza altamente não linear. Modelos computacionais se tornaram ferramentas importantes para o estudo e a compreensão de fenômenos com esse nível de complexidade, por permitirem que informações coletadas a partir de experimentos em diferentes escalas físicas sejam combinadas para se obter um entendimento melhor da funcionalidade do sistema como um todo. Como já era de se esperar, a alta complexidade dos processos biofísicos se traduz em complexos modelos matemáticos e computacionais. Os modelos cardíacos modernos são descritos por sistemas não-lineares de equações diferenciais parciais com milhões de variáveis e centenas de parâmetros. O modelo bidomínio é considerado uma das mais completas descrições da atividade elétrica do tecido cardíaco. Utilizando hipóteses apropriadas as equações do bidomínio podem ser reduzidas para um modelo mais simples, denominado monodomínio, o qual é menos intensivo computacionalmente]. Infelizmente, as simulações em larga escala, tais como as resultantes da discretização de um coração inteiro, permanecem como um desafio computacional. Apesar das dificuldades e da complexidade associadas à implementação e uso desses modelos, os benefícios e aplicações justificam seu uso. Os modelos computacionais têm sido utilizados durante testes de novos fármacos, desenvolvimento de novos dispositivos médicos e novas técnicas de diagnóstico não-invasivo para diversas doenças cardíacas. Nas simulações da eletrofisiologia cardíaca, a frente de onda que viaja pelo coração é muito fina, refletindo em uma variação rápida no potencial transmembrânico. Esta flutuação faz com que a resolução numérica das equações diferenciais parciais que modelam o fenômeno requeiram discretizações espaciais suficientemente finas para acompanhar a frente de onda, que é da ordem de 0,2 mm, a fim de assegurar resultados suficientemente precisos. A execução de simulações cardíacas em malhas com um grande número de nós tem um custo computacional alto, pois exige a solução repetida de sistemas lineares com milhões de graus de liberdade. Os requisitos de memória das simulações também representam um problema, pois tornam-se cada vez maiores. A utilização de métodos de malha adaptativa fornece uma solução para esses dois problemas. Manter a resolução extremamente fina apenas onde é necessário (isto é, nas proximidades da frente de onda) reduz significativamente o número de graus de liberdade das variáveis envolvidas, resultando em cálculos mais rápidos, um uso de memória menor e menor necessidade de uso de disco para a gravação de arquivos de saída. Outra característica a ser considerada é a dificuldade de resolver os sistemas de equações relacionados aos modelos celulares, pois estes são complexos, de natureza altamente não-linear e envolvem múltiplas escalas. Isso faz com que a simulação destes modelos demande alto poder computacional além de muito tempo, variando de acordo com a complexidade do fenômeno. Para resolver esse problema podemos utilizar métodos numéricos que são capazes de adaptar o passo de tempo. Esta adaptação de tempo tem como objetivo reduzir o tempo de execução das soluções dos sistemas de equações diferenciais ordinárias. Isso é feito aumentando o passo de tempo em regiões onde o limite de estabilidade permite. Entretanto, em regiões onde a física e/ou o refinamento da malha exigem é necessário manter o passo de tempo com valores menores, a fim de garantir que os percentuais de erro permaneçam em patamares aceitáveis.

Agregação de dados de múltiplas fontes para a compreensão da organização da sociedade humana em contextos urbanos

- Coordenador: Prof. Vinícius da Fonseca Vieira (UFSJ)

- Membros: Gustavo Henrique Martins da Costa (Mestrado – PGCC/UFSJ), Ricardo Paulo Almeida Domingos (Mestrado – PPGCC/UFSJ), Jeremias de Jesus Fernandes Ventura (Graduação – CC/BIC/UFSJ), Ronan de Souza Castro (Graduação CC/BIC/UFSJ)

- Palavras-chave: Ciência de dados; modelagem; simulação; redes sociais; computação urbana.

- Resumo: O crescimento da população em áreas urbanas tem colocado um grande desafio aos responsáveis pela elaboração de polı́ticas para planejamento urbano recentemente. A compreensão dos processos que definem a segregação nas cidades e o estudo dos seus efeitos de escala são fundamentais para um melhor planejamento e a proposta de políticas públicas que busquem mitigar os severos problemas sociais em todo o paı́s. Este projeto visa a modelagem e a compreensão das cidades como sistemas complexos, considerando a interação entre pares de indivı́duos e a interação entre indivíduos e o espaço urbano no Brasil. Dados de múltiplas fontes são agregados, como dados de registros de ligações telefônicas (Call Detail Records – CDR), dados censitários e dados de redes sociais online. Este projeto tem dois objetivos principais: desenvolver ma metodologia para analisar relacionamentos indivı́duo-indivı́duo (redes sociais) e relacionamentos indivı́duo-cidade (redes de mobilidade) em diferentes estratos sociais combinando dados CDR de alta resolução e dados censitários em diferentes regiões metropolitanas; e investigar a segregação, leis de escala e outras propriedades urbanas e estudar como essas propriedades se relacionam com redes sociais e de mobilidade. O projeto tem grande potencial de impacto sob o ponto de vista dos dados a serem explorados, da abrangência dos dados a serem explorados e da importância dos problemas a serem investigados, já que combina dados de múltiplas fontes, dados que englobam toda a extensão do Brasil e aborda problemas de grande relevância.

Caracterização de eventos e indivíduos em redes sociais de larga escala

- Coordenador: Prof. Vinícius da Fonseca Vieira (UFSJ)

- Membros: Carlos Magno Geraldo Barbosa (Mestrado – PPGCC/UFSJ), Bárbara Belize Boechat (Mestrado – PPGCC/UFSJ), Filipe Henrique Pereira Barbosa (Graduação – CC/BIC/CC/UFSJ), Felipe Francisco Rios de Melo (Graduação – CC/UFSJ)

- Palavras-chave: Redes sociais online, redes complexas, aprendizagem de máquina

- Resumo: Redes sociais online, como WhatsApp, Twitter e Facebook são utilizadas diariamente por milhares de pessoas como meio de entretenimento, comunicação, acesso à informação e reivindicações. Nesse ambiente, qualquer pessoa tem o poder de gerar e propagar notícias, resultando em novas oportunidades e dilemas, como a epidemia de desinformação e a exposição exagerada de indivíduos. Dentro desse ecossistema, bots e diferentes estratégias podem ser utilizadas por agentes com o intuito de confundir, manipular e distorcer a opinião pública sobre assuntos de seu interesse. Dessa forma, abordagens que permitam auxiliar na caracterização desse ambiente com foco no usuário tornam-se essenciais. Este projeto apresenta um conjunto de metodologias para a caracterização de eventos em larga escala centrada nos usuários em redes sociais online, em especial no Twitter. Combinando redes complexas, mineração de texto e aprendizado de máquina, investiga-se a forma como os usuários se organizam topologicamente em redes de comunicação e como podem exercer diferentes papéis dentro de suas comunidades. A partir disso, é possível realizar a identificação de contas automatizadas (bots), mapeamento de visões antagônicas sobre determinado assunto, extração de tópicos de interesse, identificação de padrões de propagação de informação e interação dos usuários de maneira semi-automatizada.